Лаборатория суперкомпьютерного моделирования

И.о. заведующего лабораторией к.ф.-м.н. Игорь Геннадьевич Черных chernykh@ssd.sscc.ru

В составе лаборатории 7 кандидатов и 3 доктора наук:

Тематика лаборатории

Разработка параллельных вычислительных методов и их эффективных программных реализаций для суперкомпьютерного моделирования в задачах лабораторной и космической плазмы и математической геофизики.

Краткая история лаборатории

В середине 90-х годов руководство ИВМиМГ СО РАН в лице директора академика Анатолия Семеновича Алексеева начали активную поддержку космических исследований в рамках задач математической геофизики. В первую очередь это были исследования в области импактных событий и метеоритной угрозы. В последующие годы в 2000-х годах учеником Анатолия Семеновича академиком Борисом Григорьевичем Михайленко начали поддерживаться исследования в области математического моделирования лабораторной и космической плазмы. Это привело к созданию в 2007 году лаборатории Параллельных алгоритмов решения больших задач, а затем её объединением в 2017 году с лабораторией Сибирский суперкомпьютерный центр. В результате была создана лаборатория Суперкомпьютерного моделирования (с функционирующим на ее базе ЦКП ССКЦ СО РАН), в которой исследования в области лабораторной и космической плазмы, наряду с геофизическими задачами, имеют приоритетное положение.

Научные направления лаборатории

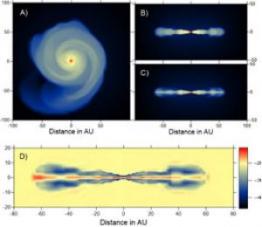

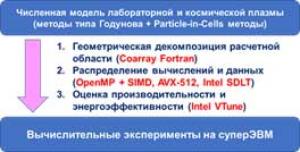

В лаборатории успешно решаются задачи вычислительной астрофизики. Так с помощью разработанных коллективом лаборатории вычислительных моделей были исследованы задачи столкновения галактик, в том числе с учетом магнитных полей, химической кинетики, процессов образования звезд и эффекта от взрыва сверхновых. Определены параметры, при которых в результате столкновения из двух галактик образуются одна, две или три галактики, а также моделировался сценарий их полного разрушения. Была подтверждена гипотеза о «нестандартности» взрыва сверхновых типа Ia, для чего была построена многоуровневая модель турбулентного горения углерода в белых карликах. Модель была использована для исследования различных сценариев столкновения белого карлика с компаньоном. В рамках модели релятивистской гидродинамики моделировался эффект обратного течения, наблюдающийся в струях, исходящих из активных ядер галактик. Для параллельной реализации вычислительных моделей космической плазмы в разное время были использованы наиболее современные архитектуры и технологии программирования: графические карты NVIDIA и технологии CUDA, ускорители Intel Xeon Phi, векторизация средствами AVX-512, язык параллельного программирования Coarray Fortran.

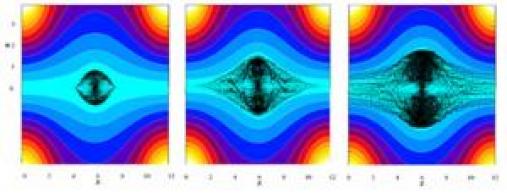

Для решения задач физики плазмы создана численная модель удержания и нагрева плазмы в осесимметричной открытой магнитной ловушке для установок управляемого термоядерного синтеза. Гибридная модель с использованием метода частиц-в-ячейках основана на кинетическом приближении для ионных компонент фоновой плазмы и инжектируемого пучка и МГД приближении для электронной компоненты. Создан комплекс программ для проведения численного моделирования диамагнитного режима ловушки, эксперименты по исследованию которого планируются на установке КОТ ИЯФ СО РАН. Проведены вычислительные эксперименты по исследованию эволюции структуры магнитного поля и плазмы, получены временные и пространственные характеристики фоновой и удерживаемой плазмы в зависимости от энергии, тока и ионного состава инжектируемого пучка и других параметров.

|

| На рисунке приведена временная эволюция конфигурации магнитного поля открытой ловушки и положение протонов инжектируемого пучка, полученная в ходе моделирования. |

В лаборатории активно ведется методологическая работа, связанная разработкой сложных трехмерных параллельных кодов. Предложена и реализована методология разработки алгоритмического и программного обеспечения для высокопроизводительных суперкомпьютеров. Разработка разбивается на три взаимосвязанных этапа: первый является расширенным определением со-дизайна, под которым мы понимаем адаптацию математического метода и вычислительного алгоритма под архитектуру суперкомпьютера на всех этапах решения задачи; на втором выполняется исследование масштабируемости алгоритмов для наиболее перспективных суперЭВМ на основе имитационного моделирования; третий этап связан с оценкой энергоэффективности алгоритма при реализации на различных архитектурах высокопроизводительных вычислительных систем.

На базе лаборатории функционирует Центр коллективного пользования «Сибирский суперкомпьютерный центр СО РАН».

Сибирский суперкомпьютерный центр

Основатель Вычислительного центра академик Г.И. Марчук уделял большое внимание развитию вычислительных мощностей, их коллективному использованию в организациях Новосибирского научного центра (ННЦ). В 1978 г. был создан Главный производственный вычислительный центр (ГПВЦ), предоставлявший вычислительные услуги институтам СО РАН. С первых лет одним из основных направлений деятельности института являлось обеспечение производственной эксплуатации крупных вычислительных машин для учреждений СО АН СССР и промышленных организаций Сибири. Важным шагом в коллективном использовании ресурсов было создание в 1985 г. Вычислительного центра коллективного пользования (ВЦКП). В этот период была построена кабельная сеть, связывавшая институты ННЦ с базовым вычислительным комплексом, состоявшим из трех БЭСМ-6 и трех ЕС 1060, расположенных в ВЦ.

В 2001 г. по инициативе директора ИВМиМГ СО РАН академика А.С. Алексеева был создан Центр коллективного пользования «Сибирский суперкомпьютерный центр СО РАН» (ЦКП ССКЦ СО РАН) на современной вычислительной базе. Позднее академик Б.Г. Михайленко продолжил работу по развитию центра. Под его руководством был запущен вычислительный кластер НКС-30Т. В 2017 году на средства субсидии ФАНО России был закуплен вычислительный кластер НКС-1П, использующий водяное охлаждение. Этот вычислительный кластер работает и сейчас, он неоднократно модернизировался и входит в список Топ 50 суперкомпьютеров России.

В настоящее время ЦКП ССКЦ СО РАН оказывает вычислительные услуги более, чем 30 институтам РАН и университетам Европейской части России и Сибири. Центр ориентирован на решение фундаментальных и прикладных задач в различных отраслях науки, а также подготовку специалистов в области суперкомпьютерных вычислений. На базе центра создана виртуальная среда для обработки данных физических экспериментов, проводимых в ИЯФ СО РАН. Приоритетные пилотные задачи, которые планируется решать в региональном суперкомпьютерном центре можно разбить по следующим категориям:

- Моделирование разведки, добычи и транспортировки углеводородов;

- Задачи информационной безопасности;

- Задачи развития сибирского и арктического регионов;

- Задачи фундаментальной науки: определение очага цунами;

- Моделирование погоды, климата и охрана окружающей среды;

- Моделирование авиакосмической техники;

- Задачи автомобильной и судостроительной промышленности;

- Нано- и биотехнологии: молекулярно-генетическое взаимодействия;

- Аналитические центры для региональных органов управления;

- Индустрия больших данных: технологии облачных вычислений; анализ генома; задачи прецизионной медицины.

Вычислительное оборудование центра состоит из двух кластеров НКС-30Т и НКС-1П с общей вычислительная мощность всего оборудования порядка 300 ТФЛОПС:

Кластер НКС-1П (произведен группа компаний РСК, охлаждение кластера осуществляется горячей водой, содержит 2448 ядер, пиковая производительность порядка 182 ТФЛОПС) имеет в своем составе:

- 27 узлов: 2 CPU Intel Xeon E5-2697v4 [128 GB DDR4, 256 GB DDR4] (всего 864 ядер, 2.6GHz) (1 узел основан 2х375GB Intel Optane [IMDT])

- 16 узлов: 1 CPU Intel Xeon Phi 7290 KNL [16 GB MCDRAM+96 GB DDR4] (всего 1152 ядер, 1.5-1.7 GHz)

- 1 узел: 2 CPU Intel Xeon Platinum 8268 [192 GB DDR4] (всего 48 ядер, 2.9 GHz)

- 8 узлов: 2 CPU Intel Xeon Gold 6248R [192/384/768 GB DDR4] (всего 384 ядер, 2.9 GHz)

- Сеть передачи данных: Intel OmniPath 100 Gb/s

- Систему хранения данных: Intel Lustre – 200 TB + NFS 100TB (собственность ИГиЛ СО РАН)

НКС-30Т (произведен компанией HP, используется воздушное охлаждение, содержит порядка 1500 процессорных ядер с частотой 2.9GHz, порядка 30 000 GPU ядер, производительность составляет порядка 85 ТФЛОПС (сегмент с GPU) + 22ТФЛОПС (процессорный сегмент)) имеет в своем составе:

- 576 CPU Intel Xeon Е5450/E5540 (всего 2688 ядер)

- 80 CPU Intel Xeon X5670 (всего 480 ядер)

- 120 GPU NVIDIA Tesla M 2090 (всего 61440 ядер)

- Сеть передачи данных: Infiniband QDR 40 Gb/s

- Систему хранения данных: HP Ibrix – 90 TB

Кластер НКС-30 |

Наиболее значимые публикации сотрудников лаборатории

- Macchi A., Cattani F., Liseykina T.V., Cornolti F. Laser acceleration of ion bunches at the front surface of overdense plasmas // Physical Review Letters. – 2005. – V. 94, I. 16. – P. 1-4.

- Palmer C. A. J., Dover N. P., Schreiber J., Najmudin Z., Pogorelsky I., Babzien M., Polyanskiy M. N., Yakimenko V., Dudnikova G.I., Ispiriyan M., Shkolnikov P. Monoenergetic proton beams accelerated by a radiation pressure driven shock // Physical Review Letters. – 2011. – V. 106, I. 1. – Article Number 014801.

- Vshivkov V. A., Naumova N. M., Bulanov S. V., Pegoraro F. Nonlinear electrodynamics of the interaction of ultra-intense laser pulses with a thin foil // Physics of Plasmas. – 1998. – V. 5, I. 7. – P. 2727-2741.

- Kulikov I., Chernykh I., Tutukov A. A new hydrodynamic code with explicit vectorization instructions optimizations, dedicated to the numerical simulation of astrophysical gas flow. I. Numerical method, tests and model problems // The Astrophysical Journal Supplement Series. – 2019. – V. 243. – Article Number 4.

- Snytnikov A.V., Vshivkov V.A., Goedheer W.J. Adaptive mass alteration to model ion–ion recombination in a Particle-in-Cell simulation of silane radio-frequency discharges // Computer Physics Communications. – 2010. – V. 181. – P. 1743-1749.

- Kulikov I. M., Chernykh I. G., Snytnikov A. V., Glinskiy B. M., Tutukov A. V. ASTROPHI: A code for complex simulation of the dynamics of astrophysical objects using hybrid supercomputers // Computer Physics Communications. – 2015. – V. 186. – P. 71-80.

- Kulikov I. A new code for the numerical simulation of relativistic flows on supercomputers by means of a low-dissipation scheme // Computer Physics Communications. – 2020. – V. 257. – Article Number 107532.

- Kulikov I., Vorobyov E. Using the PPML approach for constructing a low-dissipation, operator-splitting scheme for numerical simulations of hydrodynamic flows // Journal of Computational Physics. – 2016. – V. 317. – P. 318-346.

- Chernykh I., Kulikov I., Vshivkov V., Genrikh E., Weins D., Dudnikova G., Chernoshtanov I., Boronina M. Energy Efficiency of a New Parallel PIC Code for Numerical Simulation of Plasma Dynamics in Open Trap // Mathematics. – 2022. – Vol. 10 (11). – Article Number 3684.

- Godunov S.K., Kulikov I.M. Computation of discontinuous solutions of fluid dynamics equations with entropy nondecrease guarantee // Computational Mathematics and Mathematical Physics. – 2014. – V. 54. – P. 1012-1024.

Рабочее совещание Workshop on Numerical Modeling in MHD and Plasma Physics

Для формирования коллектива лаборатории, как одного из российских и, в перспективе, мировых лидеров в области решения задач по моделированию лабораторной и космической плазмы, было принято решение проводит ежегодные рабочие совещания с плотной насыщенной программой и с ограничением в 32 докладчика. Первое рабочее совещание Workshop on Numerical Modeling in MHD and Plasma Physics: Methods, Tools, and Outcomes было проведено 11-12 октября 2018 года в память о 90-летии академика Анатолия Семеновича Алексеева. Программный комитет рабочего совещания состоит из мировых лидеров в области моделирования лабораторной и космической плазмы, работающих как в России, так и за рубежом. С первого мероприятия было принято решение публиковать материалы конференции в рейтинговых журналах, индексируемых в Web of Science и Scopus. С 2018 по 2021 годы материалы публиковались в журнале Journal of Physics: Conference Series, с 2022 года публикуются в журнале Lobachevskii Journal of Mathematics (квартиль Q2). Это было связано с развитием рабочего совещания, которое позиционируется как одно из основных мероприятий по данной тематике в России и одно из важнейших в Мире. Так многие годы рабочее совещание информационно поддерживалось секцией по вычислительной астрофизике Международного астрономического союза. Во время пандемии рабочее совещание проводилось в онлайн формате и было одним из немногих регулярных мероприятий, которое не прерывалось на время коронавирусных ограничений. Важно отметить, что в 2018 и 2019 годах часть докладов была проведена с использованием онлайн формата. Этот опыт позволил оперативно перестроить работу рабочего совещания. С 2023 года был возобновлен очный формат работы.

MHD-PP-2018 (Новосибирск) |

MHD-PP-2019 (Москва) |

MHD-PP-2020 (Виртуальный формат) |

MHD-PP-2023 (Москва) |

В настоящее время ежегодное рабочее совещание Workshop on Numerical Modeling in MHD and Plasma Physics: Methods, Tools, and Outcomes является лидирующим в области суперкомпьютерного моделирования лабораторной и космической плазмы как в России, так и за рубежом.

Участие лаборатории в конференциях

Сотрудники лаборатории активно участвуют в конференциях как в России, так и за рубежом.

Серия конференций |

Серия суперкомпьютерных |

Серия конференций «ACM/IEEE Supercomputing Conference» (США) |

Конференция Cosmic Streams 2023 |

Конференция COSMO 2022 |

Конференция XMM-Newton 2019 |

Кроме этого, сотрудники лаборатории традиционно принимают активное участие в конференциях ИВМиМГ СО РАН, такие как «Марчуковские научные чтения» и «Параллельные вычислительные технологии».

Крупные проекты лаборатории

Грант РНФ 16-11-10028 «Высокопроизводительное моделирование турбулентных режимов генерации высокочастотного электромагнитного излучения в системе плазма — релятивистский электронный пучок» (руководитель – д.ф.-м.н. Вшивков В.А.)

Грант РНФ 18-11-00044 «Разработка, реализация и исследование эффективных параллельных вычислительных методов для решения уравнений гидродинамики с использованием технологии вложенных сеток на массивно-параллельных суперЭВМ» (руководитель – д.ф.-м.н. Куликов И.М.)

Грант РНФ 19-71-20026 «Численное моделирование открытых плазменных ловушек для решения задач управляемого термоядерного синтеза с использованием перспективных высокопроизводительных вычислительных систем» (руководитель – к.ф.-м.н. Черных И.Г.)

Грант РНФ 23-11-00014 «Разработка, реализация и исследование вычислительных методов высокого порядка точности для решения уравнений специальной релятивистской гидродинамики с использованием адаптивных сеток на суперЭВМ» (руководитель – д.ф.-м.н. Куликов И.М.)

Грант РФФИ 19-51-14002 «Моделирование образования звезд на массивно параллельных суперкомпьютерах» (руководитель – д.ф.-м.н. Куликов И.М.)

Экспертная деятельность

Сотрудники лаборатории осуществляют экспертную деятельность по проектам Российской академии наук, грантам Российского научного фонда и Российского фонда фундаментальных исследований, а также по проектам Национального швейцарского научного фонда. Экспертиза кандидатских и докторских диссертаций осуществляется сотрудниками лаборатории в рамках диссертационных советов ИВМиМГ СО РАН, НГУ и НГТУ.

Преподавательская деятельность

Сотрудники лаборатории читают лекции, проводят практические занятия и осуществляю научное руководство студентами и аспирантами на механико-математическом факультете НГУ и факультете прикладной математики и информатики НГТУ.